방명록

- GAN(2), AI 관련 지식(1)2024년 03월 12일 06시 54분 55초에 업로드 된 글입니다.작성자: 재형이반응형

- 아니 어제 문제 풀이 앱 만들다가 12시를 넘겨서 자버렸다...

- 근데 요즘 매일 4시에 일어나다보니, 별로 안 잔 것 같은데 피곤하지가 않네;; 굳

사실 조금 피곤하긴함ㅋ - 오늘도 핫식스로 시작해보는 하루이다...

1. DCGAN

- Generator는 training set을 단순히 암기하거나 copy하지 않는다

- Generator의 input z를 조금씩 변경하여 생성한 이미지도 완전히 다른 이미지가 나오는 것이 아니라 조금씩 변경되는 형태로 생성되는 것으로 보아, latent space의 어떤 점과 생성된 값이 1:1로 매칭되는 형태가 아님을 알 수 있었다.

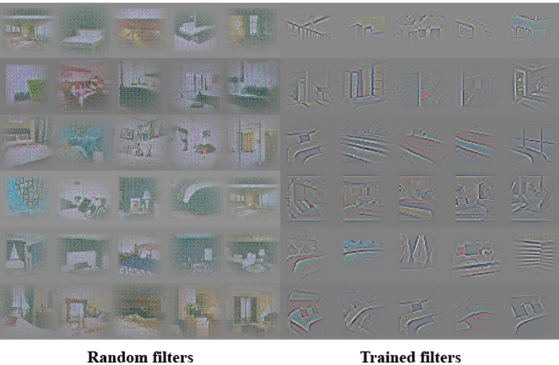

- Generator에서 생성된 filter는 특정 object를 생성하는 역할을 수행한다

- 예를 들어서 어떤 filter는 창문을 생성하는 filter라면 그 filter를 제외하고 생성한 이미지에는 창문이 존재하지 않는다.

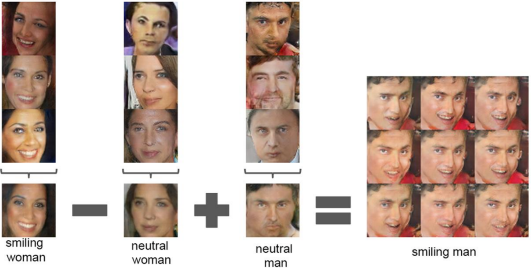

- DCGAN은 벡터 산술 연산이 가능하고, 그 결과 생성되는 이미지를 조절할 수 있다

- 웃는 여성 – 무표정 여성 + 무표정 남성 = 웃는 남성의 연산이 가능하다.

2. GAN의 활용

2-1. Pix2Pix

- Image-to-Image Translation with Conditional Adversarial Networks

2-2. CycleGAN

- Unpaired Image-to-Image Translation using Cycle-Consistent Adversarial Networks

2-3. DiscoGAN

- Learning to Discover Cross-Domain Relations with Generative Adversarial Networks

2-4. StyleGAN GAN

https://github.com/NVlabs/stylegan 2-5. Font Generation

- zi2zi: Master Chinese Calligraphy with Conditional Adversarial Networks

https://kaonashi-tyc.github.io/2017/04/06/zi2zi.html

2-6. Cartoon Generation GAN

- Towards the Automatic Anime Characters Creation with Generative Adversarial Networks

2-7. Text to Image GAN

- Generative Adversarial Text to Image Synthesis

https://arxiv.org/pdf/1605.05396.pdf 2-8. Face Aging GAN

- Age Progression/Regression by Conditional Adversarial Autoencoder (CAAE)

https://github.com/ZZUTK/Face-Aging-CAAE 2-9. Super resolution GAN

- GP-GAN: Towards Realistic High-Resolution Image Blending (ACMMM 2019, oral)

2-10. Anomaly detection GAN

https://github.com/AndersonJo/gan-yhat 3. 인공신경망 학습의 문제점

- 어떻게 신경망을 설계해야 좋은 성능을 보일지 모르겠다

- 설정해야 할 하이퍼파라미터가 너무 많음

- 데이터가 충분하지 않다

- 학습하는데 시간이 너무 오래 걸린다

3-1. Transfer Learning

- 이미 잘 학습된 모델을 가지고 파인튜닝하여 사용하자

- 유사한 Task를 수행하는 신경망의 학습 파라미터를 재사용

3-2. Meta Learning

Meta-Learning in Neural Networks: A Survey, Timothy Hospedales et al. 2020 - 어떻게 하면 학습을 잘 시킬 수 있을까?에 대한 방법들

3-2-1. Fewshot Learning

- 데이터 간의 유사도를 측정하는 함수를 학습

- k-way n-shot

- k: 클래스의 개수

- n: 클래스가 가진 샘플 수

- 일반적인 신경망의 학습

- 지정된 범주에 속하는 정도를 판단

- Few shot learning의 학습

- 데이터 간의 유사도를 학습

- Siamese Network

반응형'인공지능 > 인공지능 기초' 카테고리의 다른 글

머신러닝 Learning Path (0) 2024.04.09 AI 관련 지식(2) (2) 2024.03.13 Auto Encoder, GAN(1) (0) 2024.03.11 NLP (3) (0) 2024.03.10 NLP (2) (0) 2024.03.09 다음글이 없습니다.이전글이 없습니다.댓글